De Autoriteit Persoonsgegevens waarschuwt dat wij onszelf onvoldoende bewust zijn van de risico’s van algoritmes en kunstmatige intelligentie. Door AI liggen desinformatie, privacyovertredingen en discriminatie op de loer.

In het kort:

- De Autoriteit Persoonsgegevens waarschuwt voor de risico’s van de snelle ontwikkeling en inzet van algoritmes en kunstmatige intelligentie (AI).

- AI kan leiden tot de verspreiding van desinformatie, privacyovertredingen en discriminatie, met name als het wordt getraind met niet-representatieve data.

- Ondanks deze risico’s biedt AI kansen voor efficiëntie en welzijn, bijvoorbeeld in de gezondheidszorg, waar het kan bijdragen aan bijvoorbeeld snellere diagnoses.

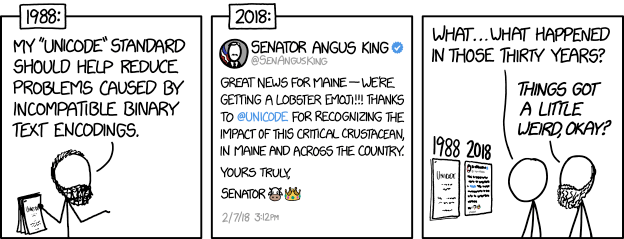

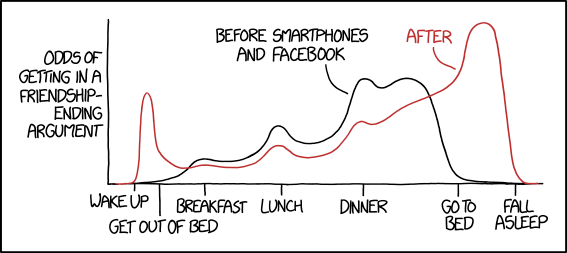

De toenemende inzet van kunstmatige intelligentie en technologische innovaties gaan volgens de privacywaakhond Autoriteit Persoonsgegevens sneller dan we als samenleving kunnen bijhouden. Het gevolg daarvan is dat we een achterstand hebben wat betreft het herkennen van de risico’s. Maar ook bij de aanpak ervan, via bijvoorbeeld regelgeving en handhaving.

Het toeslagenschandaal laat zien welke gevaren algoritmes voor onze privacy vormen. Tienduizenden mensen kwamen in de problemen doordat ze door algoritmes als fraudeur werden bestempeld. Maar kunstmatige intelligentie gaat volgens experts nog een stap verder.

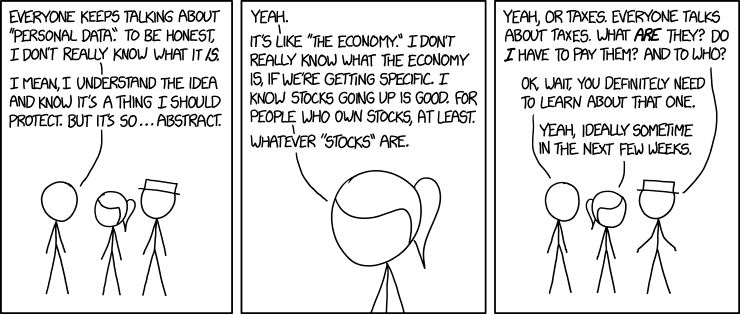

Sinds de komst van de AI-chatbot ChatGPT schermt nagenoeg elk techbedrijf met kunstmatige intelligentie. Maar AI is niets anders dan een hoopje algoritmes, zegt docent Rajiv Girwar van de Hogeschool Rotterdam. “Zodra een algoritme conclusies kan trekken of iets nieuws kan genereren, noemen we het AI.”

Algoritmes en kunstmatige intelligentie moet je volgens privacyexpert Rejo Zenger van Bits of Freedom zien als een zwarte doos. “Je stopt bepaalde data in de doos, maar je hebt geen zicht op wat er in die doos met de data wordt gedaan. Daarna rolt er een conclusie uit of rollen er nieuwe data uit, maar je hebt geen idee hoe dat tot stand is gekomen.”

Ontvang een melding bij nieuwe ontwikkelingen.

Risico op privacyschending, discriminatie en desinformatie

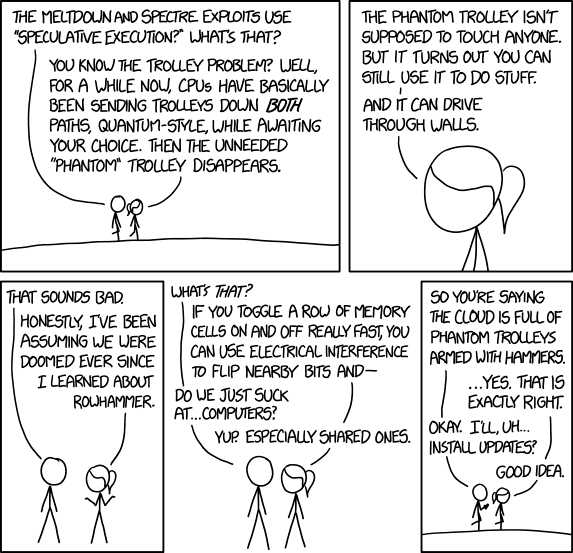

Je kunt algoritmes en kunstmatige intelligentie loslaten op alle data die je kunt vinden op het internet. Bijvoorbeeld op de locatiegegevens van miljoenen Nederlanders die online verkrijgbaar zijn. Je zou vervolgens AI kunnen laten analyseren wie zich mogelijk met criminele zaken bezighoudt. Dat is een behoorlijke inbreuk op jouw privacy.

De risico’s van kunstmatige intelligentie zijn afhankelijk van de data waarmee AI wordt getraind, legt privacyadvocaat Céline van Waesberge van Project Moore Advocaten uit. Met niet-representatieve trainingsdata ligt bijvoorbeeld discriminatie en het genereren van verkeerde informatie (desinformatie) op de loer.

Een goed voorbeeld van niet-representatieve data zie je bijvoorbeeld in de zorg. “Daar is van oudsher veel medische kennis over mannen”, schetst Van Waesberge. “Als je een AI-model uitsluitend daarmee traint, is de uitkomst mogelijk niet betrouwbaar voor bijvoorbeeld kinderen of vrouwen.”

AI wordt vaak getraind met niet-representatieve data

Daarnaast moeten mensen in ons land volgens Van Waesberge in veel gevallen toestemming geven voordat een AI-model met hun privacygevoelige gezondheidsdata mag worden getraind. Het risico bestaat dat bepaalde groepen mensen toestemming geven en andere groepen mensen niet.

Daardoor kunnen bepaalde groepen mensen oververtegenwoordigd zijn in de trainingsdata en andere groepen ondervertegenwoordigd. Het gevolg is dat de data waarmee AI wordt getraind niet representatief zijn.

“De conclusies die een AI-model trekt en de informatie die het systeem genereert, zijn sterk afhankelijk van de data die je erin hebt gestopt”, onderstreept ook Zenger. “We gaan ervan uit dat beslissingen van computers neutraal zijn, maar doordat de data vaak niet representatief zijn, kunnen gegenereerde informatie en conclusies onjuist en zelfs discriminerend zijn.”

Toezicht op AI staat hoog op de agenda

Vanwege al die risico’s staat het toezicht op algoritmes en kunstmatige intelligentie dit jaar hoog op de agenda van de Autoriteit Persoonsgegevens. “In ons toezicht geven we prioriteit aan klachten, datalekken en onderzoeken die over algoritmes en AI gaan.”

“We zijn sinds januari 2023 ook coördinerend algoritmetoezichthouder in Nederland”, vervolgt de privacywaakhond. “Dat doen we voor de bescherming van publieke waarden en grondrechten bij de inzet van algoritmes en AI.”

Het vertrouwen van de Nederlandse burger in algoritmes en AI is klein, concludeert de Autoriteit Persoonsgegevens. Maar dat is niet helemaal terecht. “De technologie kan ook bijdragen aan duurzame welvaart en welzijn.”

Kunstmatige intelligentie biedt veel kansen

“Kunstmatige intelligentie heeft niet alleen een duistere kant”, benadrukt ook privacyadvocaat Van Waesberge. “In bijvoorbeeld de zorg moeten we het echt omarmen. Er zijn al voorbeelden dat AI kanker beter kan herkennen dan het menselijk oog.”

Maar kunstmatige intelligentie gaat de arts echt niet vervangen, denkt Van Waesberge. “AI kan helpen om sneller een goede diagnose te stellen en bepaalde andere taken over te nemen”, zegt de privacyadvocaat. “Daardoor houdt de arts tijd over voor bijvoorbeeld meer persoonlijk contact of om meer patiënten te helpen. Dat kan de zorg efficiënter en dus goedkoper maken, en voor meer vertrouwen in de zorg zorgen.”